Jeżeli byliście na szkoleniu Narzędziownik AI od Tomka Turby, to wiecie jak relatywnie łatwo jest przeprowadzić atak wstrzyknięcia złośliwego promptu (ang. prompt injection), np. na model LLM – ChatGPT. Jeżeli mamy taką możliwość podczas interakcji z LLM’em 1:1, to czy możemy zrobić to samo, jeżeli AI jest wykorzystywane jako usprawnienie…

Czytaj dalej »

Badacze z Aim Security odkryli pierwszą podatność „zero-click” w agencie sztucznej inteligencji (AI). Microsoft 365 Copilot można było zmusić agenta do wyciekania poufnych danych organizacji bez ingerencji przez użytkownika – ofiarę. Wystarczyła wysyłka jednego, odpowiedniego spreparowanego maila. Podatność otrzymała oznaczenie CVE-2025-32711 z oceną CVSS 9.3 (krytyczna) i została ochrzczona przez…

Czytaj dalej »

W naszym ostatnim tekście przybliżyliśmy problemy opisane przez firmę Legit, które pozwalały na wykorzystanie asystenta Duo do kradzieży poufnych informacji z prywatnych repozytoriów lub zmuszania modelu LLM do wykonywania niepożądanych przez prawowitego właściciela projektu działań. Jak można się było domyślić, poruszana tematyka jest związana raczej z architekturą rozwiązań niż z…

Czytaj dalej »

Agenty LLM na stałe wpisały się w dziedzinę rozwoju oprogramowania. Chociaż nie zanosi się na to, aby miały zastąpić programistów, to ich integracja ma znacznie ułatwić i przyspieszyć ich pracę. Oprócz narzędzi takich jak Cursor.sh (IDE wspierane generatywnym AI) firmy oferujące platformy do przechowywania kodu w repozytoriach Git (GitHub i…

Czytaj dalej »

Są tu jacyś fani sztucznej inteligencji? Z poprzednich szkoleń z tego tematu wiemy, że jest Was już ponad 120 000, więc nie zwalniamy tempa i 20 maja br. wracamy ponownie z naszym topowym szkoleniem Poznaj AI. Praktyka, narzędzia, ciekawostki! Możesz wbić na szkolenie całkowicie za darmo, możesz nas wesprzeć jakąś…

Czytaj dalej »

Ostatnie badania zespołu HiddenLayer ujawniły poważną lukę w zabezpieczeniach dużych modeli językowych (LLM), takich jak GPT-4, Claude, Gemini czy Llama. Nowa technika, nazwana „Prompt Puppetry”, pozwala na obejście mechanizmów bezpieczeństwa tych modeli, umożliwiając generowanie treści, które normalnie byłyby zablokowane, czyli klasyczny już jailbreaking. Czym jest „Prompt Puppetry”? „Prompt Puppetry” to…

Czytaj dalej »

Pierwsze koty za płoty: przekroczyliśmy już barierę 100 000 osób przeszkolonych w zakresie AI! 🎉 Tak jest, dobrze czytasz – sto tysięcy ludzi uczestniczyło w naszych szkoleniach otwartych (Poznaj AI, Narzędziownik AI, Hackowanie vs. AI), zamkniętych (dla dedykowanych Klientów) i prelekcjach dot. AI na konferencjach (w tym MEGA Sekurak Hacking Party…

Czytaj dalej »

Cellebrite to znana firma, która produkuje narzędzia do “analizy kryminalistycznej” smartfonów. Z jej usług korzystają służby na całym świecie. O Cellebrite jest znowu głośno w związku z raportem Amensty International dotyczącym szpiegowaniu studenta w Serbii (ma to związek z licznymi protestami w tym kraju). Niedawno wprowadzili do swoich produktów funkcje…

Czytaj dalej »

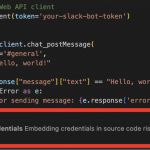

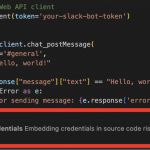

Przeszukiwanie zasobów w poszukiwaniu kluczy API nie jest nowatorską praktyką i bywa bardzo często wykorzystywane przez atakujących na etapie rekonesansu. Powstały liczne narzędzia, które potrafią przeszukiwać np. repozytoria kodu (np. na GitHubie). Sytuacje, w których produkcyjne poświadczenia trafiają do publicznych baz danych nie są wyjątkiem, dlatego nic dziwnego, że badacze…

Czytaj dalej »

Wprowadzenie integracji dużych modeli językowych (Large Language Model, LLM) ze środowiskami programistycznymi może okazać się zbawienne w przypadku pisania tzw. boiler plate code (czyli szablonów). Nudne i powtarzalne zajęcie, to idealne zadanie dla sztucznej inteligencji. Jednak zachłyśnięcie się technologią oraz poszukiwanie na siłę oszczędności może prowadzić do katastrofalnych skutków. Dlaczego?…

Czytaj dalej »

W dzisiejszych czasach znajomość narzędzi AI staje się kluczowa. Dlaczego? Ponieważ AI może znacząco zwiększyć efektywność pracy, automatyzując powtarzalne zadania, pozwalając skupić się na bardziej kreatywnych i strategicznych działaniach „ludzkich”. Narzędzia AI są coraz bardziej zintegrowane z różnymi branżami, od IT po finanse, co oznacza, że umiejętność ich wykorzystania może…

Czytaj dalej »

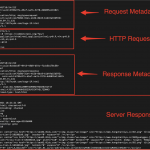

Na stronie CERT/CC pojawiła się szczegółowa notatka dotycząca nowej metody obejścia zabezpieczeń produktu firmy OpenAI – ChatGPT-4o. Jak większość produkcyjnie dostępnych dużych modeli językowych (LLM), tak i ChatGPT posiada zabezpieczenia, które mają na celu uniemożliwić lub ograniczyć odpowiedzi na niektóre tematy. Metoda “przekonania” modelu do odpowiedzi na zakazane pytania nosi…

Czytaj dalej »

DeepSeek – to nazwa chińskiego startupu, który podniósł i odrzucił rękawicę rzuconą między innymi przez OpenAI w zakresie użyteczności modeli LLM. W ostatnich dniach, jest odmieniana w mediach przez wszystkie przypadki. Jednak w tym wyścigu technologicznym, pośpiech nigdy nie będzie dobrym doradcą. Firma Wiz opublikowała niepokojący wpis informujący o znalezieniu…

Czytaj dalej »

Daisy, bo tak nazywa się ten eksperymentalny bot, zamienia głos rozmówcy na tekst. Tekst jest następnie wprowadzany do dedykowanego LLMa, który generuje odpowiedź tekstową. Odpowiedź jest czytana rozmówcy (scammerowi) głosem starszej osoby. Wszystko dzieje się w czasie rzeczywistym. Sieć O2 ma dwa cele: 1) Zajęcie jak największej ilości czasu scammerom2)…

Czytaj dalej »

Poniższe obrazki wydają się jednakowe; czy jesteś w stanie określić, czym się różnią? Przykład adwersarialny z wykorzystaniem FGSM, Źródło: TensorFlow, https://www.tensorflow.org/tutorials/generative/adversarial_fgsm?hl=pl Mam mocne przeczucie, że nie widzisz różnicy. Natomiast dla AI (sieci neuronowej) mogą to być dwa absolutnie różne obrazki; ten po lewej przedstawia pandę, a drugi – rzecz jasna –…

Czytaj dalej »