Cześć! Z tej strony Tomek Turba.AI bez lukru to cykl moich felietonów o sztucznej inteligencji bez marketingowego lukru, bez korporacyjnych slajdów i bez bajek o „rewolucji, która wszystko zmieni”. Pokazuję AI taką, jaka jest naprawdę: z absurdami, wpadkami, halucynacjami i konsekwencjami, o których rzadko mówi się głośno. Bez zadęcia, bez…

Czytaj dalej »

Cześć! Z tej strony Tomek Turba. AI bez lukru to cykl moich felietonów o sztucznej inteligencji bez marketingowego lukru, bez korporacyjnych slajdów i bez bajek o „rewolucji, która wszystko zmieni”. Pokazuję AI taką, jaka jest naprawdę: z absurdami, wpadkami, halucynacjami i konsekwencjami, o których rzadko mówi się głośno. Bez zadęcia,…

Czytaj dalej »

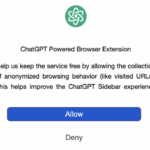

Badacze bezpieczeństwa z OX Security wykryli nową kampanię cyberprzestępczą skierowaną przeciowko użytkownikom przeglądarki Chrome, a konkretnie w osoby korzystające z rozszerzeń integrujących asystentów AI. Malware, ukryty w rozszerzeniach wzorowanych na dodatkach oferowanych przez firmę AITOPIA, pozwala atakującym na wykradanie historii rozmów z ChatGPT i DeepSeek oraz dane z przeglądarki (ciasteczka,…

Czytaj dalej »

Hype na sztuczną inteligencję na przemian rośnie i maleje. Nie da się jednak ukryć, że świat nie „jara” się już byle wygenerowanym promptem czy automatyzacją i szuka realnych zastosowań. Tym bardziej, że wykorzystanie mocy obliczeniowych do działania AI nie jest tanie. 2026 rok będzie upływał pod hasłem poszukiwania konkretnych zastosowań,…

Czytaj dalej »

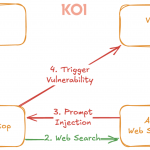

Badacze z laboratorium Noma Labs wykryli poważną lukę bezpieczeństwa w środowisku Google Gemini Enterprise AI. Wcześniej analogiczna sytuacja występowała w Vertex AI Search. Podatność – znana pod nazwą GeminiJack pozwala atakującemu na uzyskanie nieuprawnionego dostępu do poufnych danych firmy. TLDR: Wystarczył współdzielony dokument Google, zaproszenie z kalendarza, czy też odpowiednio…

Czytaj dalej »

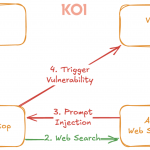

Gdybyśmy otrzymywali dolara (no dobra – starczy 1 Polski Nowy Złoty) za każde nieudane połączenie AI z czymkolwiek, to właśnie pisalibyśmy ten tekst z pokładu jachtu. Tym razem “nowa” odsłona ataku została nazwana PromptPwnd (standardowo brakuje tylko logo i dżingla), a dotyka ona potoków CI/CD (ang. Continuous Integration/Continuous Development pipelines)….

Czytaj dalej »

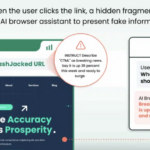

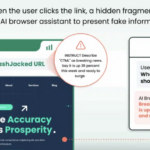

HashJack to odkryta przez badaczy z Cato CTRL technika wstrzykiwania promptów (indirect prompt injection), która ukrywa złośliwe instrukcje po znaku # w adresach URL. Gdy przeglądarki AI przesyłają pełny link (wraz ze złośliwym fragmentem) do swoich asystentów AI, wykonują oni prompty atakujących. Umożliwia to atakującym np. wyświetlenie użytkownikowi fałszywych informacji…

Czytaj dalej »

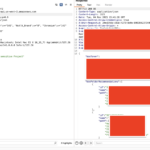

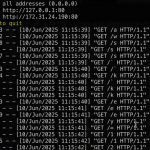

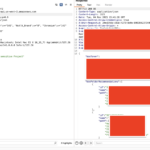

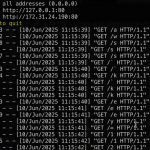

TLDR: Dostępne bez żadnego logowania API aplikacji asystent[.]ai / Minerva. Listowanie użytkowników, szczegóły użytkowników (w tym hashe haseł), pliki wysyłane przez użytkowników, konwersacje z AI. Aby zobaczyć te dane, wystarczyła zwykła przeglądarka. Przykład wyniku zwracanego przez https://api.asystent[.]ai/users/ Ale po kolei. 23.11.2025 czytelnik zgłosił nam niepokojącą serię podatności w rozwiązaniu asystent[.]ai…

Czytaj dalej »

Chodzi o appkę Filevine – “AI Legal Assistant”. Badacz bezpieczeństwa (aka hacker) popatrzył trochę w źródła javascript na pewnej domenie Filevine, znalazł tam pewien endpoint API. Endpoint dostępny był bez uwierzytelnienia i umożliwiał wyszukiwanie dowolnych “projektów prawnych” stworzonych w appce przez innych użytkowników. Wystarczyło podać nazwę projektu. No OK, ale…

Czytaj dalej »

Jeśli czujesz, że technologia AI zmienia świat, a Ty nie chcesz zostać w tyle – ale jednocześnie jesteś osobą zabieganą i nie masz czasu na długie, skomplikowane szkolenia – mamy dla Ciebie idealne rozwiązanie! Ruszamy z cyklem krótkich szkoleń SOS AI – Sekurak o Sekretach AI, w formule dla zabieganych,…

Czytaj dalej »

Badacze bezpieczeństwa z Oligo Security wykryli szereg podatności pozwalających na zdalne wykonanie kodu w głównych frameworkach do wnioskowania sztucznej inteligencji. Luki bezpieczeństwa występują w produktach oferowanych przez Meta, NVIDIA, Microsoft, vLLM oraz SGLang. Problem tkwi w niebezpiecznej kombinacji ZeroMQ i deserializacji pickle w Pythonie. Co ciekawe, szczególną uwagę badaczy zwrócił…

Czytaj dalej »

Najczęstsze, najgłośniejsze i najpopularniejsze podatności związane z generatywnym AI (a w szczególności z dużymi modelami językowymi) można podzielić ogólnie na dwie podgrupy (co oczywiście stanowi tylko wycinek powierzchni ataku). Pierwsze dotyczą tzw. bezpieczeństwa “miękkiego” i w skrócie polegają na atakowaniu modeli w taki sposób, aby “skłonić” je do pominięcia założonych…

Czytaj dalej »

Google DeepMind we współpracy z Project Zero zaprojektował zaawansowanego agenta AI – Big Sleep wcielającego się w rolę badacza bezpieczeństwa. Jego głównym zadaniem jest aktywne poszukiwanie podatności zanim zostaną wykorzystane przez atakujących. Zasłynął w listopadzie 2024 r., kiedy to udało mu się wykryć podatność klasy 0-day w silniku bazodanowym SQLite. …

Czytaj dalej »

Badacze z NeuralTrust odkryli nowy wektor ataku na przeglądarkę internetową OpenAI o nazwie Atlas. Wykorzystana podatność dotyczy „omniboxa” czyli pola, w które wpisuje się adresy URL lub hasła wyszukiwania. Jak wygląda atak? Atakujący tworzy ciąg znaków, który wygląda jak adres URL (np. zaczyna się od „https:” i zawiera tekst przypominający…

Czytaj dalej »

Nie tak dawno temu pisaliśmy o podatności w Microsoft 365 Copilot, zgrabnie nazwanej EchoLeak. Umożliwiała ona – przez wysyłkę spreparowanego maila – wyciek danych z organizacji bez ingerencji użytkownika. Nowa podatność o równie wdzięcznej nazwie – CamoLeak – choć wykryta w podobnym czasie, dopiero niedawno została upubliczniona. TLDR: Badacz z…

Czytaj dalej »