Generatywne modele językowe przebojem wdarły się do naszej codzienności. Dziś już wielu nie wyobraża sobie codziennej pracy czy nauki bez ich udziału. Rozwój dużych modeli językowych wpłynął także na obraz zagrożeń w cyberprzestrzeni. Z jednej strony LLM-y mogą pomagać w obronie, z drugiej strony stwarzają zupełnie nowe możliwości dla podmiotów…

Czytaj dalej »

Gdybyśmy otrzymywali dolara (no dobra – starczy 1 Polski Nowy Złoty) za każde nieudane połączenie AI z czymkolwiek, to właśnie pisalibyśmy ten tekst z pokładu jachtu. Tym razem “nowa” odsłona ataku została nazwana PromptPwnd (standardowo brakuje tylko logo i dżingla), a dotyka ona potoków CI/CD (ang. Continuous Integration/Continuous Development pipelines)….

Czytaj dalej »

Od pewnego czasu na łamach sekuraka pojawia się coraz więcej informacji łączących bezpieczeństwo IT oraz sztuczną inteligencję (najczęściej mowa o generatywnej SI, a dokładniej dużych modelach językowych). Boom, a właściwie bańka AI zdaje się rosnąć w zatrważającym tempie. Jednak patrząc na rzeczywiste zdolności modeli w działaniach ofensywnych – jak na…

Czytaj dalej »

Open WebUI to otwartoźródłowa, samodzielnie hostowana platforma AI. Można korzystać z niej na własnym serwerze, ale również lokalnie na urządzeniu. Obsługuje różne interfejsy LLM, takie jak Ollama i API kompatybilne z OpenAI. TLDR: W październiku 2025 badacz zgłosił podatność XSS występującą w aplikacji. 21 października została załatana, a 7 listopada…

Czytaj dalej »

Badacze bezpieczeństwa z Oligo Security wykryli szereg podatności pozwalających na zdalne wykonanie kodu w głównych frameworkach do wnioskowania sztucznej inteligencji. Luki bezpieczeństwa występują w produktach oferowanych przez Meta, NVIDIA, Microsoft, vLLM oraz SGLang. Problem tkwi w niebezpiecznej kombinacji ZeroMQ i deserializacji pickle w Pythonie. Co ciekawe, szczególną uwagę badaczy zwrócił…

Czytaj dalej »

Systemy agentowe, duże modele językowe oraz już-nie-taka-nowość (chociaż wciąż zyskujące popularność) serwery MCP gościły na łamach sekurak.pl wielokrotnie. Pod jednym z artykułów, gdzie opisywaliśmy możliwe wektory ataków na serwery MCP, można było spotkać głosy sceptycznie podchodzące do tematu niebezpiecznych serwerów. Dlatego tym razem chcielibyśmy przedstawić atak, którego wystąpienie było tylko…

Czytaj dalej »

Anton Cherepanov, badacz bezpieczeństwa z firmy ESET podczas rutynowej analizy próbek wrzucanych na portal VirusTotal, odkrył nowy wariant malware. Jego uwagę zwrócił plik (kod napisany w Golang), zawierający odwołanie do modelu gpt-oss-20b oraz instrukcje sterujące (prompty), umożliwiające generowanie potencjalnie złośliwych skryptów bezpośrednio w systemie ofiary. Nowo wykryty malware został rozpoznany…

Czytaj dalej »

Nie da się ukryć, że LLMy na stałe wpisały się w krajobraz naszej rzeczywistości. Dodatkowo, szczególną rolę, odgrywają w świecie IT, gdzie stają się nieodzownym elementem narzędzi, np. środowisk programistycznych. Generowanie kodu, podpowiadanie składni, przygotowanie dokumentacji czy także także dodatkowe funkcjonalności dostępne dzięki rozwiązaniu Model Context Protocol, o którym już…

Czytaj dalej »

Niedawno pisaliśmy o różnych aspektach bezpieczeństwa rozwiązania MCP. Jednak to nie wszystkie zagrożenia, z którymi muszą mierzyć się inżynierowie wdrażający rozwiązania oparte o AI. W przypadku dużych dostawców oczekiwania rozbudowy funkcjonalności są spore. Brak odpowiedniego modelowania zagrożeń, może okazać się krytyczny z punktu widzenia bezpieczeństwa. Badacze z Eye Research opisali…

Czytaj dalej »

Proton, znany z takich usług jak Proton Mail czy Proton VPN, zaprezentował nowy produkt: Lumo, narzędzie AI zaprojektowane z myślą o pełnej ochronie danych. Firma podkreśla, że Lumo nie przechowuje żadnych logów konwersacji po stronie serwera, nie wykorzystuje promptów użytkowników do trenowania modeli AI, stosuje szyfrowanie typu zero‑access, dzięki czemu nawet Proton…

Czytaj dalej »

Tematy związane z agentami LLM jeszcze przez długi czas będą na czele gorących zagadnień. Głównie za sprawą usprawnień i automatyzacji. Jednak wprowadzany na prędce standard MCP oraz wiele rozwiązań na nim bazujących to wciąż świetne miejsce do nadużyć. Ostatnio opisywaliśmy moduł mcp-remote i zagrożenia z nim związane. W skrócie jest…

Czytaj dalej »

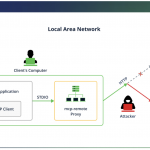

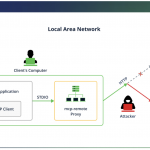

O tym, czym jest Model Context Protocol pisaliśmy na łamach sekuraka już nie raz. W skrócie, jest to ustandaryzowany protokół pozwalający na rozszerzenie możliwości dużych modeli językowych (LLM, Large Language Models). Dzięki niemu LLMy mogą korzystać z zewnętrznych narzędzi udostępnianych przez serwery MCP w sposób ujednolicony, bez konieczności implementowania tzw….

Czytaj dalej »

Model Context Protocol (MCP) szybko staje się fundamentem nowoczesnych systemów agentycznych AI, łącząc modele językowe z zewnętrznymi narzędziami i danymi. Jednak wraz z masowym przyjęciem tej technologii pojawiają się nowe, wysoce zaawansowane wektory ataków, które wykraczają daleko poza tradycyjne luki bezpieczeństwa. Badacze z m.in. CyberArk, Invariant Labs i Straiker AI…

Czytaj dalej »

W naszym ostatnim tekście przybliżyliśmy problemy opisane przez firmę Legit, które pozwalały na wykorzystanie asystenta Duo do kradzieży poufnych informacji z prywatnych repozytoriów lub zmuszania modelu LLM do wykonywania niepożądanych przez prawowitego właściciela projektu działań. Jak można się było domyślić, poruszana tematyka jest związana raczej z architekturą rozwiązań niż z…

Czytaj dalej »

Agenty LLM na stałe wpisały się w dziedzinę rozwoju oprogramowania. Chociaż nie zanosi się na to, aby miały zastąpić programistów, to ich integracja ma znacznie ułatwić i przyspieszyć ich pracę. Oprócz narzędzi takich jak Cursor.sh (IDE wspierane generatywnym AI) firmy oferujące platformy do przechowywania kodu w repozytoriach Git (GitHub i…

Czytaj dalej »