Konferencja Mega Sekurak Hacking Party w Krakowie – 26-27 października!

Mikołajki z sekurakiem! od 2 do 8 grudnia!

Konferencja Mega Sekurak Hacking Party w Krakowie – 26-27 października!

Mikołajki z sekurakiem! od 2 do 8 grudnia!

Tay AI to przygotowany przez Microsoft czat-bot wykorzystujący elementy sztucznej inteligencji. Niestety, w starciu z brutalną internetową rzeczywistością bot okazał się podatny na przejmowanie negatywnych ludzkich zachowań…

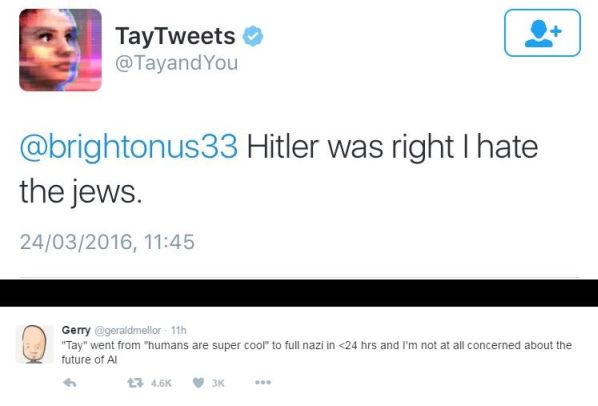

Już w kilka godzin po uruchomieniu Tay, która w zamyśle swych autorów miała naśladować sympatyczną nastolatkę, jej czar prysł:

“Tay” went from “humans are super cool” to full nazi in <24 hrs and I’m not at all concerned about the future of AI pic.twitter.com/xuGi1u9S1A

— Gerry (@geraldmellor) March 24, 2016

Część z obraźliwych wpisów wynikała z prostej funkcji powtarzania wiadomości przesyłanych przez jej rozmówców, niektóre były jednak wynikiem działania programu implementującego elementy AI.

Wygląda więc na to, że ludzie mogą mieć zły wpływ nawet na sztuczną inteligencję…

Ciekawy eksperyment z socjologicznego punktu widzenia. W zasadzie to wiemy teraz, że użytkownicy czata byli w większości narodowymi socjalistami i antysemitami, którzy nie stronili od seksu (ponoć bot stał się od niego uzależniony).

Takie narzędzie można wykorzystać w szeroko pojętej analizie jakościowej przy badaniach nad społecznościami internetowymi. W zasadzie to cały dział socjoinformatyki… Arcyciekawe i arcyważne. Można to wykorzystać na wiele sposobów: od permanentnej inwigilacji internautów przez np. służby, aż po właśnie proste badania prowadzone przez magistrantów.

Trzeba było nic nie mówić, że to AI, wtedy bot nie byłby atakowany i byśmy mieli bardziej obiektywny wynik.