Konferencja Mega Sekurak Hacking Party w Krakowie – 26-27 października!

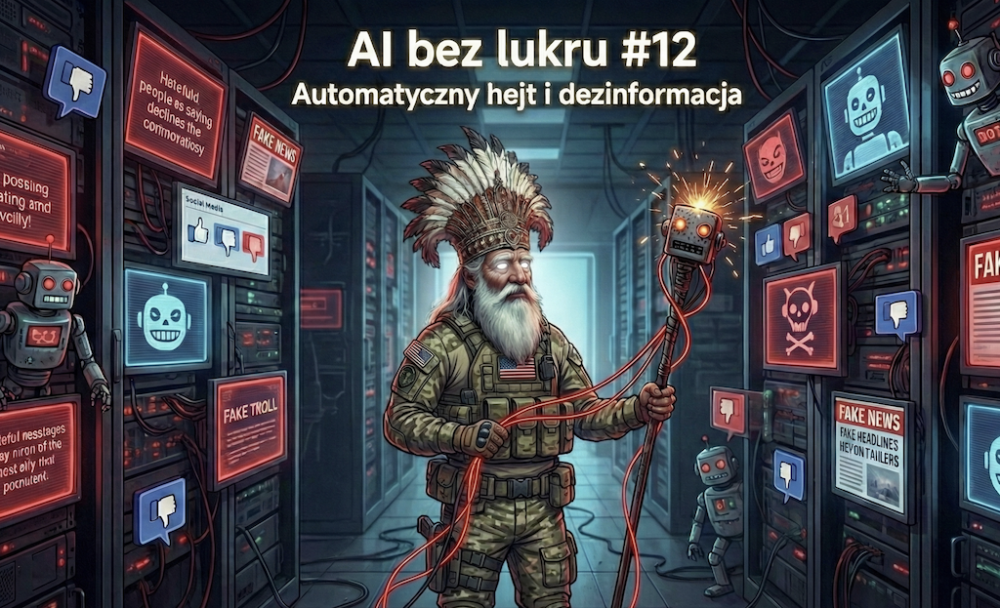

AI bez lukru #12: Automatyczny hejt i dezinformacja – boty, które robią nagonki za sajgonki

Cześć! Z tej strony Tomek Turba. AI bez lukru to cykl moich felietonów o sztucznej inteligencji bez marketingowego lukru, bez korporacyjnych slajdów i bez bajek o „rewolucji, która wszystko zmieni”. Pokazuję AI taką, jaka jest naprawdę: z absurdami, wpadkami, halucynacjami i konsekwencjami, o których rzadko mówi się głośno. Bez zadęcia, bez propagandy, z humorem – ale na serio.

Pełna lista odcinków: tutaj

Chcesz ogarnąć ze mną niezbędne umiejętności dotyczące AI w 2026 roku i tym samym nie zostać w tyle? Już dziś startuje kolejna edycja szkolenia ze mną, Tomkiem Turbą – Narzędziownik AI 2.0 Reloaded! To najbardziej kompletne szkolenie z AI w Polsce. Składa się z aż czternastu sesji, trwających po dwie godziny każda. Szkolenie na żywo, z dostępem do nagrania na zawsze. Skorzystaj z linku i zamów z 70-procentową zniżką.

Kiedyś, żeby kogoś publicznie zniszczyć, trzeba było się postarać. Trzeba było mieć ludzi, czas, argumenty, no i minimum odwagi, żeby powiedzieć coś pod własnym nazwiskiem. Dziś? Dziś wystarczy budżet, prompt i kilka tysięcy kont, które nie są ludźmi.

Hejt się zautomatyzował. Nie dlatego, że ludzie nagle stali się bardziej agresywni. Dlatego, że agresja stała się skalowalna.

Boty nie mają emocji, ale perfekcyjnie je udają. Wiedzą, kiedy użyć oburzenia, kiedy ironii, a kiedy „troski”. Potrafią w pięć minut wygenerować falę komentarzy, która wygląda jak spontaniczna reakcja społeczeństwa. A to nie jest społeczeństwo. To bardzo wydajny skrypt utworzony na podstawie promptu systemowego.

Dezinformacja? To w sumie problem podobnej klasy, ale cięższego kalibru. Widziałeś to setki razy. Jedno zdanie wyrwane z kontekstu. Jedna odpowiedź wygenerowana bez filtra. Jeden screen bez źródła. I nagle algorytm odpala alarm: trenduje. W ciągu godziny masz „powszechne oburzenie”, w ciągu dwóch – wezwania do bojkotu, a wieczorem ktoś już tłumaczy się, że „nie miał takich intencji”. Idealnym przykładem była niedawna afera z Grokiem (modelem uruchomionym z inicjatywy Elona Muska). Model, odpowiadając na pytanie o obozy koncentracyjne w kontekście historycznym i technicznym, użył sformułowania o cyklonie B jako środku do dezynfekcji i walki z insektami. Formalnie – fakt (jest to insektycyd). Kontekstowo – pole minowe. Internet nie potrzebował więcej. Zanim ktokolwiek zdążył się zastanowić, w jaki sposób zostało zadane pytanie, jaki był pełny kontekst odpowiedzi i czy to była próba relatywizacji, czy suchy opis, automatyczny hejt już pracował. Screeny, skróty, nagłówki. Boty poszły pierwsze. Potem dołączyli ludzie. Nagonka ruszyła jak z automatu: „AI wybiela nazizm”, „Algorytm relatywizuje zbrodnie”, „To dowód, że AI jest niebezpieczna”. Mało kogo interesowało, że to klasyczny przykład źle ustawionego kontekstu + literalnej odpowiedzi + algorytmicznego podkręcenia emocji. Liczył się efekt. A efekt był idealny do eskalacji. Komuś na tym zależało. I tu jest sedno problemu.

Algorytmy platform nie pytają, czy oburzenie jest uzasadnione. Pytają, czy jest intensywne. A boty potrafią generować intensywność hurtowo. Setki niemal identycznych komentarzy, te same słowa klucze, ta sama narracja, tylko przestawione zdania. „Wszyscy mówią”, „Internet nie wybacza”, „To skandal”. Internet nic nie mówi. Internet jest karmiony. Trolli jest dużo, ale trolli AI – jeszcze więcej. Są kraje, w których boty robią kampanie polityczne. Są takie, gdzie robią nagonki na dziennikarzy, lekarzy, nauczycieli.

Są sytuacje, gdy jeden źle wygenerowany akapit wystarcza, żeby rozpętać cyfrowy lincz, który nie ma już nic wspólnego z prawdą, tylko z dynamiką algorytmu. Najgorsze jest to, że człowiek w tym mechanizmie jest dodatkiem. Mięsem. Punktem danych. Bot nie nienawidzi. Bot realizuje cel z chirurgiczną precyzją. Dla AI nie ma znaczenia, czy niszczy reputację modelu, firmy czy konkretnej osoby, a może historii. Liczy się zasięg i reakcja. A my, proste „mechanizmy”, robimy resztę za darmo. Klikamy. Udostępniamy. Dopisujemy swoje trzy grosze. I nawet jeśli wydaje nam się, że tylko „patrzymy z boku”, to w rzeczywistości dokładamy cegiełkę do trwającej nagonki, którą ktoś zaprojektował, zaplanował i wypuścił jak kampanię reklamową.

Najgorsze jest to, że w tym mechanizmie nie ma już miejsca na wyjaśnienia. Tłumaczenie się jest traktowane jak przyznanie się do winy. Kontekst wygląda jak wymówka. Cisza – jak potwierdzenie. Każda reakcja jest zła, bo algorytm już zdecydował, że dramat ma trwać.

“Cancel Culture as a Service” w wersji maszynowej nie potrzebuje moralności. Potrzebuje zaangażowania. I właśnie dlatego jest groźniejsza niż klasyczny hejt. Bo nie wygląda jak atak. Wygląda jak „opinia publiczna”.

Puenta jest brutalna: w epoce AI najgroźniejszy hejt czy dezinformacja to nie te, które ktoś stworzył pod wpływem emocji. Najgroźniejsze są te, który zostały wygenerowane, zoptymalizowane i wypuszczone w obieg bez kontekstu, a potem podchwycone przez ludzi szybciej, niż zdążyli pomyśleć. Paradoksem jest to, że człowiek ma domyślnie włączone Deep Reasoning. Jednak im dłużej lewituję po tym Matriksie, tym bardziej się przekonuję, że może on się zawiesić.

~Tomek Turba

Smutne, ale zastanawiam się czy dzięki możliwościom AI można zrobić coś na odwrót, czyli coś dobrego na dużą skalę, a jeśli tak to co możemy my maluczcy

Nie insektoid, tylko insektycyd.

Dzięki, poprawione!