Konferencja Mega Sekurak Hacking Party w Krakowie – 26-27 października!

Aardvark – agent od OpenAI, który wykrywa, eksploituje i łata podatności. Wynik: 10 CVE w projektach open-source

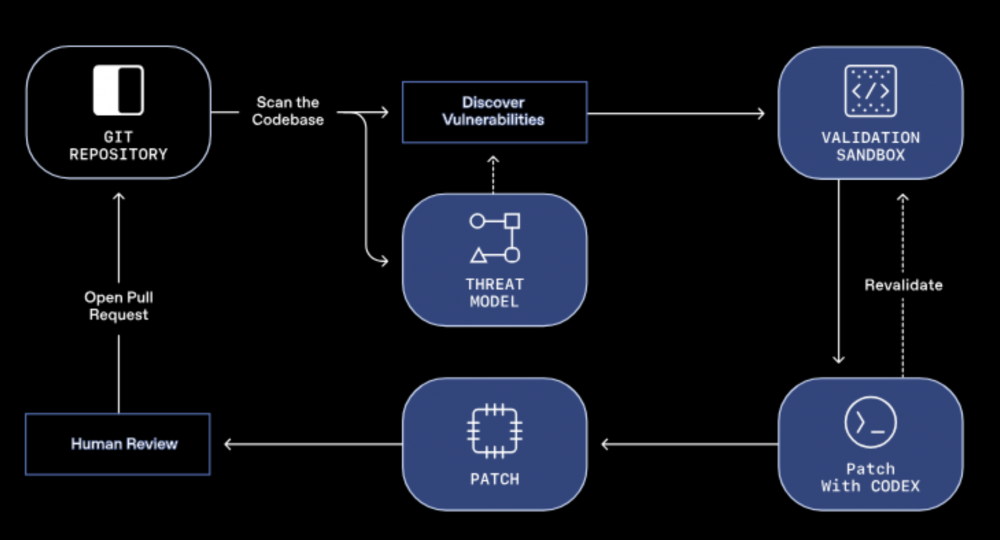

OpenAI informuje o udostępnieniu Aardvarka – agenta opartego na GPT-5, który wciela się w rolę badacza bezpieczeństwa z możliwością skanowania setek repozytoriów jednocześnie. Po otrzymaniu dostępu do repozytorium skanuje kod, wykrywa podatności, testuje je w sandboksie, żeby potwierdzić czy ich użycie jest realne, a następnie proponuje poprawki (po integracji z Codex).

TLDR:

- OpenAI udostępnia Aardvarka – agenta bezpieczeństwa AI opartego na GPT-5, działającego w pełni autonomicznie.

- Obecnie jest dostępny w wersji beta dla wybranych partnerów OpenAI.

- Po integracji z projektem, potrafi wykryć podatności, przetestować je w bezpiecznym środowisku, a następnie zaproponować poprawki.

- Wyniki są obiecujące: 10 CVE w projektach open-source i skuteczność na poziomie 92% (testy przeprowadzono na specjalnie przygotowanych repozytoriach, w których umieszczono znane podatności).

Brzmi trochę marketingowo, OpenAI twierdzi, że zostało wykrytych 10 podatności w projektach open-source, które po weryfikacji otrzymały identyfikatory CVE oraz udało się osiągnąć 92% skuteczności w testowych repozytoriach, co ma stanowić bardzo dobry wynik. Niestety, informacja na temat konkretnych klas podatności, ich skomplikowanie oraz numery CVE nie zostały przedstawione. Nie ma również wzmianek na temat tzw. false positive, które agent zaklasyfikował, jako możliwe podatności. Agent nie jest jeszcze dostępny publicznie, obecna wersja-beta jest otwarta dla wybranych partnerów.

Zasada działania

Na rynku istnieje sporo narzędzi pozwalających na ocenę i automatyczne poprawianie aplikacji. Weźmy np. Github Copilot od Microsoftu, który udziela sugestii kodu w czasie rzeczywistym, a nawet jest w stanie samodzielnie wygenerować testy jednostkowe, Google Gemini Code Assist realizującego podobne zadania, czy też lokalne modele działające offline. Występuje wśród nich jeden wspólny mianownik, są to asystenci wspierający pracę dewelopera. Generują kod, udzielają pomocy podczas debugowania i wykrywania błędów, opracowują dokumentację, asystują na każdym etapie wytwarzania oprogramowania. Developer tworzy prompt, asystent generuje propozycje odpowiedzi i to od niego zależy czy zaakceptuje proponowane rozwiązanie. W przedstawionych przypadkach AI jest narzędziem w rękach programisty w modelu interaktywnym – pytanie i odpowiedź.

Aardvark z definicji działa w zupełnie inny sposób. Jest w pełni autonomicznym agentem, który po dodaniu do repozytorium, rozpoczyna automatyczne skanowanie. W pierwszym kroku generuje model zagrożeń (threat model), indywidualny dla każdego projektu, biorąc głównie pod uwagę jego architekturę. Następnie śledzi wprowadzane zmiany (commity) i testuje ich wpływ na cały projekt. Wykryte podatności weryfikuje w bezpiecznym środowisku sandboxowym przygotowanym przez platformę OpenAI, a następnie generuje patche. Nie wymaga promptów czy też innej interakcji z zespołem deweloperskim, jest w pełni samodzielny.

Można powiedzieć, że działa podobnie do zaawansowanego systemu analizy statycznej kodu (SAST),

z dużą większym oknem kontekstowym i LLM po drodze, tzn.: monitoruje kod, analizuje wprowadzane zmiany, uruchamia szereg testów, pod kątem wykrycia nieprawidłowości. Takie podejście pozwala na głębsze zrozumienie logiki oprogramowania, co może prowadzić do wykrywania błędów, które tradycyjne narzędzia SAST mogłyby przeoczyć.

Jak widać na powyższym schemacie, Aardvark po wygenerowaniu patcha automatycznie otwiera pull request do sprawdzenia. Dopiero po zaakceptowaniu, zaproponowane zmiany mogą zostać zmergowane i wdrożone w projekcie (o ile administrator nie zdefiniował innej procedury).

Dobre praktyki wymagają, aby to człowiek był ostatnim ogniwem, w procesie wytwarzania oprogramowania. To właśnie on powinien zapoznać się z wykrytym błędem, zrozumieć co się wydarzyło i jakie mogą być jego konsekwencje, a następnie ocenić zaproponowaną poprawkę i ewentualnie ją wdrożyć. Po drugie compliance: w większości firm, automatyczne commity do głównego brancha, bez code review są z definicji zabronione.

Plany na przyszłość

Śledząc aktywność czołowych graczy na rynku AI, można zauważyć wyraźny wyścig, w opracowaniu autonomicznych agentów bezpieczeństwa. Google wdrożył projekt Big Sleep – agenta pełniącego rolę pentestera, analizującego kod i wykrywającego podatności. W sierpniu zasłynął z wykrycia podatności w silniku Chrome, której nadano identyfikator CVE-2025-9132.

Open AI odpowiedziało Aardvarkiem i chociaż nie jest dostępny publicznie dla szerszego grona, biorąc pod uwagę wyniki przedstawione przez OpenAI, zapowiada się obiecująco. Na razie działa w modelu chmurowym, bez możliwości wdrożenia on premise, co niesie za sobą pewne konsekwencje. Nie każda firma będzie chciała się dzielić swoim know-how z OpenAI.

Zapewne wiele osób nurtuje pytanie, czy rzeczywiście agent zastąpi pentestera? Odpowiedź nie jest jednoznaczna, jednak nadal z przewagą na mocne “nie”. To prawda, narzędzia usprawniają pracę, pozwalają na analizę dużo większej ilości danych oraz wpływają na szybsze podejmowanie decyzji. Z drugiej strony testy bezpieczeństwa to coś więcej niż korzystanie z gotowych narzędzi. W tej branży wymagana jest kreatywność, adaptacja do nowych sytuacji, doświadczenie, podejmowanie decyzji w oparciu o niepełne informacje i tzw. intuicja.

Należy również pamiętać, że nie w każdym systemie istnieje możliwość wykorzystania narzędzi AI do realizacji testów i często od wymagań klienta zależy w jakiej formie będą one realizowane. Tak czy inaczej, przyszłość zapowiada się ciekawie. Narzędzi AI będą nieocenionym wsparciem, ale nie stanowią bezpośredniego zagrożenia dla pracy pentestera.

Źródło: openai.com

~_secmike

Świetny pomysł, twórca curl się znowu ucieszy ze AI spamu